DeepSeek-R1 登上《Nature》封面的背后

今天,DeepSeek 的大型语言模型 DeepSeek-R1 的研究成果,作为封面文章登上了国际顶尖科学期刊《Nature》。这一事件不仅标志着 DeepSeek 在人工智能领域的重大突破,也引发了业界和学术界的广泛关注。

成本与影响

与 OpenAI 那些动辄上千万美元的模型不同,DeepSeek-R1 仅花费了 30 万美元进行训练。这一低成本高效率的训练方式,不仅展示了 DeepSeek 在技术上的创新,也引发了美股的震荡,显示出其在市场上的巨大影响力。

技术细节与创新

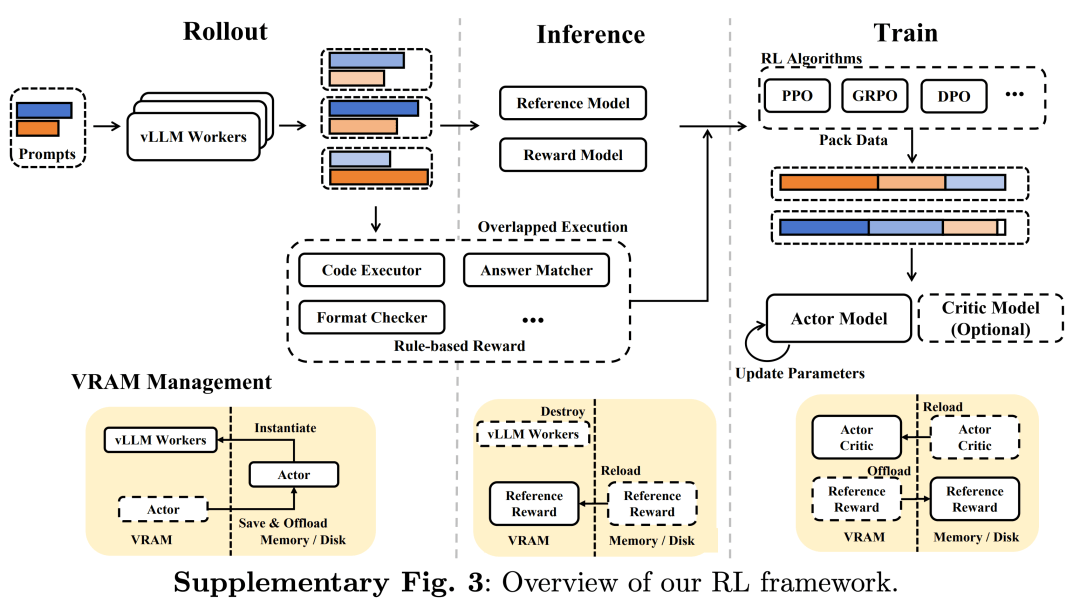

此次登上《Nature》封面的文章,是 DeepSeek 年初在 arXiv 公布的论文《DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning》。虽然大体上与年初的论文相似,但补充了相当多的细节。正文只有双栏 11 页,补充材料却达到了 83 页,而同行评审文件也有 64 页之多。

这些新公开的资料,让我们看到了 DeepSeek R1 详细的训练流程,以及团队首次披露的训练 R1 推理能力的关键成本,仅为 29.4 万美元。

为什么是 DeepSeek?

尽管 DeepSeek R1 不一定是全球最强的大语言模型,但它却是第一个经过独立同行评审的大语言模型。这不仅让 R1 的科学价值获得了认可,也为整个行业树立了一个新的标杆。

同行评审的意义

同行评审意味着要公开更多细节,可能涉及商业机密。同时,它要求提供证据、接受外部质询。而这一次,DeepSeek 把 R1 模型送进了学术体系,让 8 位独立专家逐条审查,并公开了审稿意见与作者回复。

这不仅让 R1 的科学价值获得了认可,也为整个行业立下了一个新标杆。大模型不只是公司的黑箱,它们也可以经受专业科学的检验。

技术突破

DeepSeek-R1 最核心的贡献是证明了纯强化学习(pure reinforcement learning, RL)可以有效激发 LLM 的推理能力,无需依赖人类标注的思维路径,自己学会推理。

传统的大模型提升推理能力,往往需要人类手动提供大量思考链条(chain-of-thought),让模型模仿。但这样的问题是,需要人工标注,成本高,不可持续;其次是受限于人类思维,模型只能学人类的套路,难以探索新的推理路径。

R1 的方法完全不同,它只给模型一个奖励信号,“答案对了就加分,错了就减分”;不规定中间推理步骤,让模型自己去探索。

结果与评估

结果是,R1 在训练过程中出现了类似“自我反思、验证、动态调整”的行为。例如,它会在回答过程中说“等等,我需要重新检查这一步”,这种反思片段就是所谓的涌现式推理能力。

在公开测试中,R1 在数学竞赛 AIME 2024 的准确率达到 77.9%,远高于人类平均水平,甚至在部分代码和理科推理任务上超过了 GPT-4。

总结

DeepSeek-R1 登上《Nature》封面不仅是对 DeepSeek 技术实力的认可,也是对整个 AI 行业的一个重要里程碑。通过同行评审的过程,DeepSeek 为大语言模型的研究和开发树立了一个新的标准,推动了 AI 技术的科学化进程。